Inhalt

- Was ist A/B-Testing?

- 3 Beispiele für A/B-Testing

- Diese Tools unterstützen erfolgreiches A/B-Testing

- Fazit zum erfolgreichen A/B-Testing

Das Wichtigste in Kürze

- A/B-Tests ermöglichen datenbasierte Optimierung der Conversion-Rate durch gezielte Website-Änderungen.

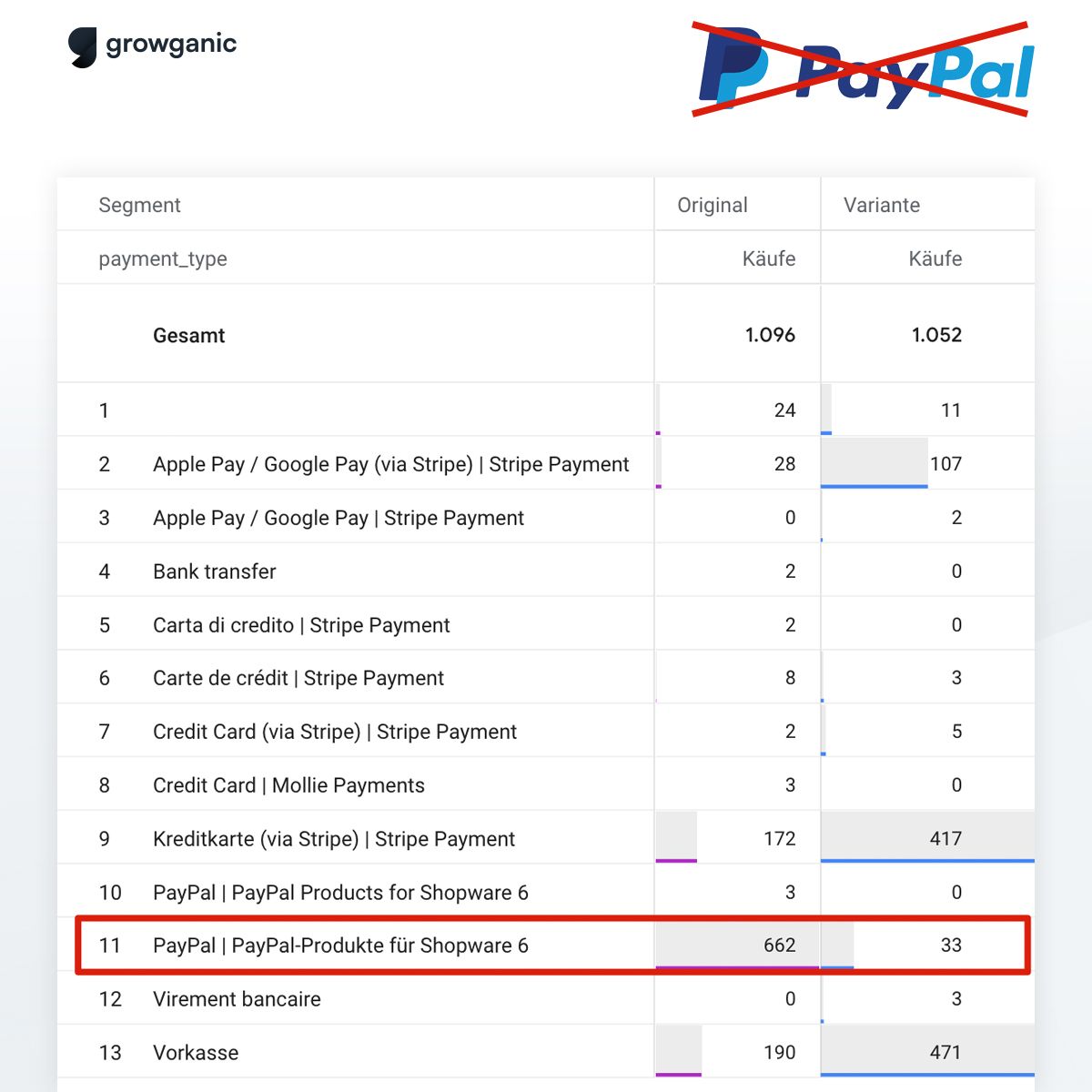

- Beispiel PayPal: Entfernung führte nur zu minimalem Conversion-Rückgang, senkte aber Gebühren deutlich.

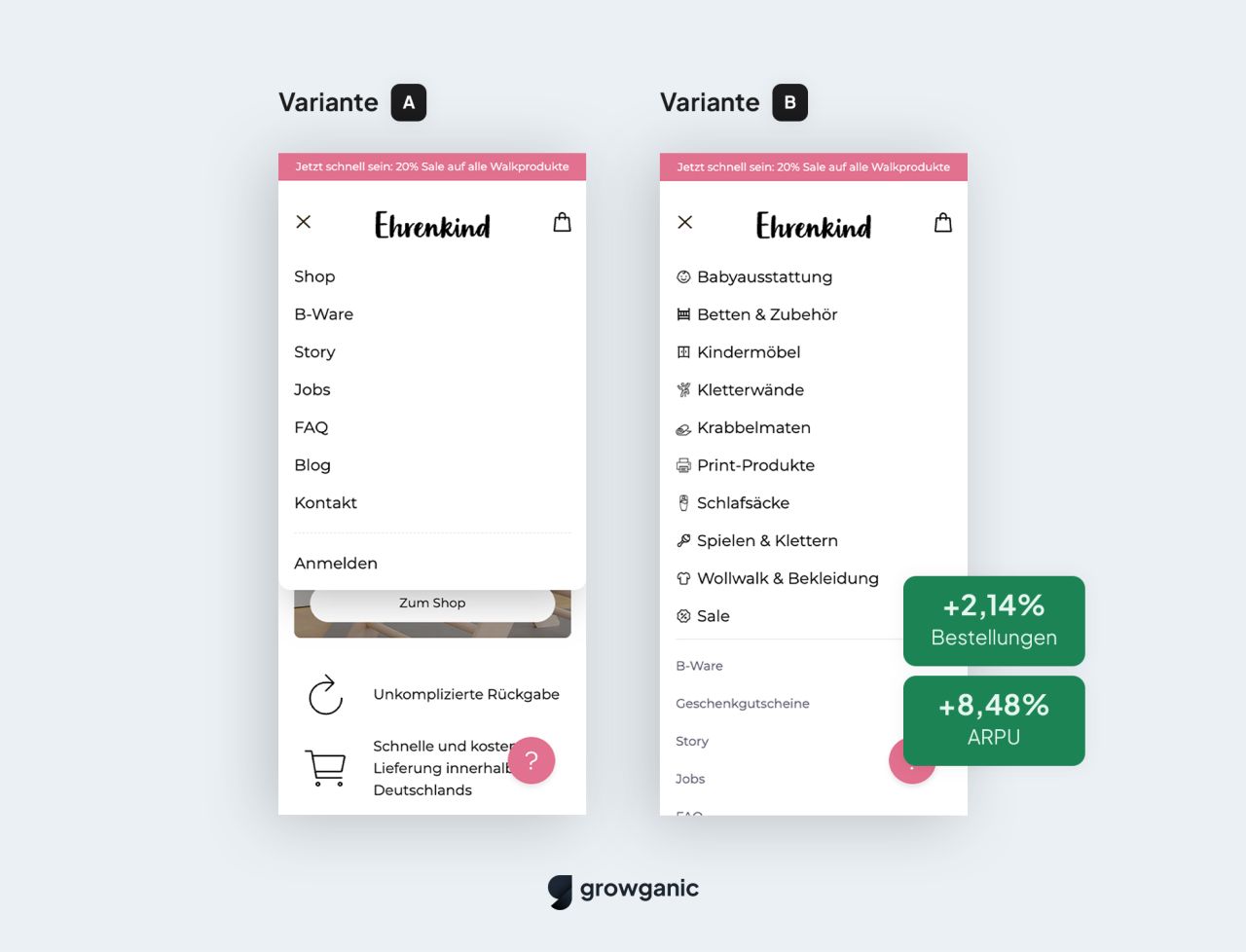

- Navigation optimieren kann den Umsatz spürbar steigern, wie bei Ehrenkind mit +2,14 % mehr Bestellungen.

- Social Proof mit Promis bei yfood führte zu weniger Bestellungen – nicht jede gängige Methode wirkt.

- Paywall-Design und andere Maßnahmen wie Geld-zurück-Garantien sollten immer getestet statt blind umgesetzt werden.

Um mehr Umsatz über deine Website zu erzielen, gibt es zwei Hebel: mehr Traffic und eine bessere Conversion-Rate. Während die Trafficerhöhung Zeit, Aufwand oder Werbeausgaben benötigt, kannst du eine bessere

Conversion-Rate oft durch simple Maßnahmen und kleine Änderungen auf deiner Website erreichen.

Doch einfach Best Practices umzusetzen, führt in den seltensten Fällen zum Erfolg. Welche Änderungen wirkliche Verbesserungen bringen, kannst du mit A/B-Tests herausfinden. Sie ermöglichen es, datenbasiert und risikofrei Hypothesen zu testen und so die Conversion-Rate nachhaltig zu optimieren.

Was ist A/B-Testing?

A/B-Testing bezeichnet den Prozess, bei dem Versionen eines Systems (z. B. einer Website) verglichen werden, um herauszufinden, welche davon ein definiertes Ziel besser erreicht.

A/B-Tests werden häufig im Online-Marketing eingesetzt, um Verbesserungen an der Website auf Basis von Daten durchzuführen und nicht von Bauchgefühl.

- Häufig gewinnt nicht die favorisierte Variante

- Viele Tests sind indifferent, also es gibt keinen klaren Gewinner

Aus diesem Grund benötigt es häufig mehrere A/B-Tests nacheinander, um messbare Verbesserungen an der eigenen Website festzustellen. Zudem sollten bei

A/B-Tests grundlegende Dinge beachtet werden, um maximale Erkenntnisse aus den Experimenten zu ziehen, beispielsweise sollte ein bestimmtes Konfidenzniveau erreicht werden, um die Hypothese zu validieren.

Hier findest du 5 Beispiele von erfolgreichen A/B-Tests aus unterschiedlichen Branchen, von denen du dich für deine nächste Testkampagne inspirieren lassen kannst.

3 Beispiele für A/B-Testing

Kein PayPal als Bezahlmethode mehr?

In vielen Onlineshops ist

PayPal die mit Abstand

beliebteste Bezahlmethode. Händler*innen schätzen die hohe Akzeptanz, Käufer*innen vertrauen auf den Käuferschutz. Doch PayPal bringt auch Nachteile mit sich: eingefrorene Guthaben, hohe Gebühren und Probleme mit der Liquidität. Ein mutiger Shop wollte deshalb wissen, was passiert, wenn man PayPal komplett entfernt – und testete genau das.

Die Hypothese: Nutzer*innen würden auf alternative

Zahlungsmethoden wie Apple Pay oder Kreditkarte ausweichen, ohne dass die Conversion-Rate signifikant sinkt.

Im A/B-Test wurde Variante B ohne PayPal gegenüber der bisherigen Zahlungsübersicht (inkl. PayPal) getestet.

Das Ergebnis war überraschend eindeutig:

- Die Conversion-Rate sank nur minimal.

- Die Nutzer*innen wichen auf andere Zahlungsmethoden aus – insbesondere Apple Pay und klassische Kreditkartenzahlung.

- Besonders auffällig: Die Payment-Gebühren sanken deutlich, was sich positiv auf den Deckungsbeitrag auswirkte.

Ein Test, der zeigt: Auch vermeintlich gesetzte Dinge und „No-Brainer“ wie PayPal können zur Debatte stehen – wenn datengetrieben getestet wird.

Bessere Navigation, besserer Umsatz – Ehrenkind steigert Bestellungen um 2,14 %

Bei mobilen Shops entscheidet oft die Navigation darüber, ob Nutzer*innen schnell zum passenden Produkt finden oder abspringen. Die Kindermarke Ehrenkind überarbeitete ihre mobile Hauptnavigation in einem gezielten A/B-Test.

Während die ursprüngliche Variante eher schlicht und generisch war, rückte Variante B wichtige Produktkategorien in den Fokus und strukturierte die Navigation neu: Hauptkategorien wie „Babyausstattung“ oder „Wollwalk & Bekleidung“ wurden nach oben gezogen, weniger relevante Inhalte optisch reduziert.

Die Resultate sprechen für sich:

- +2,14 % mehr Bestellungen

- +8,48 % höherer durchschnittlicher Umsatz pro Nutzer (ARPU)

Der Test zeigt, wie unterschätzt Navigation als Umsatzhebel im

E-Commerce ist. Schon kleine strukturelle Änderungen mit klarerem Fokus auf die Kundensicht können große Wirkung entfalten.

-6 % Bestellungen: Social Proof mit Promis floppt bei yfood

Social Proof gilt als bewährter Hebel zur Conversion-Optimierung.

Große Marken, bekannte Gesichter und beeindruckende Zahlen sollen Vertrauen schaffen.

Die bekannte Trinkmahlzeiten-Marke

yfood testete genau das – und stellte ein prominentes Element mit Influencer-Stimmen (darunter bekannte Gesichter wie

Fritz Meineke von 7vsWild) und Bestellstatistiken direkt auf die Produktseite.

Die Erwartung war klar: Mehr Vertrauen durch bekannte Gesichter müsste für mehr Conversions sorgen und dadurch einen höherer ARPU und mehr Umsatz erzeugen.

Doch der A/B-Test zeigte ein anderes Bild:

- 6,06 % weniger Bestellungen

- 5,00 % niedrigerer ARPU

- Statistisch signifikant mit über 95% Konfidenz

Die Erkenntnis nach dem Test:

Nicht jede „No-Brainer“-Idee liefert positive Ergebnisse.

Selbst etablierte Erfolgsfaktoren wie Social Proof funktionieren nicht automatisch – Zielgruppe, Zeitpunkt und Umsetzung entscheiden.

Nur wer testet, kann wirklich wissen, was funktioniert.

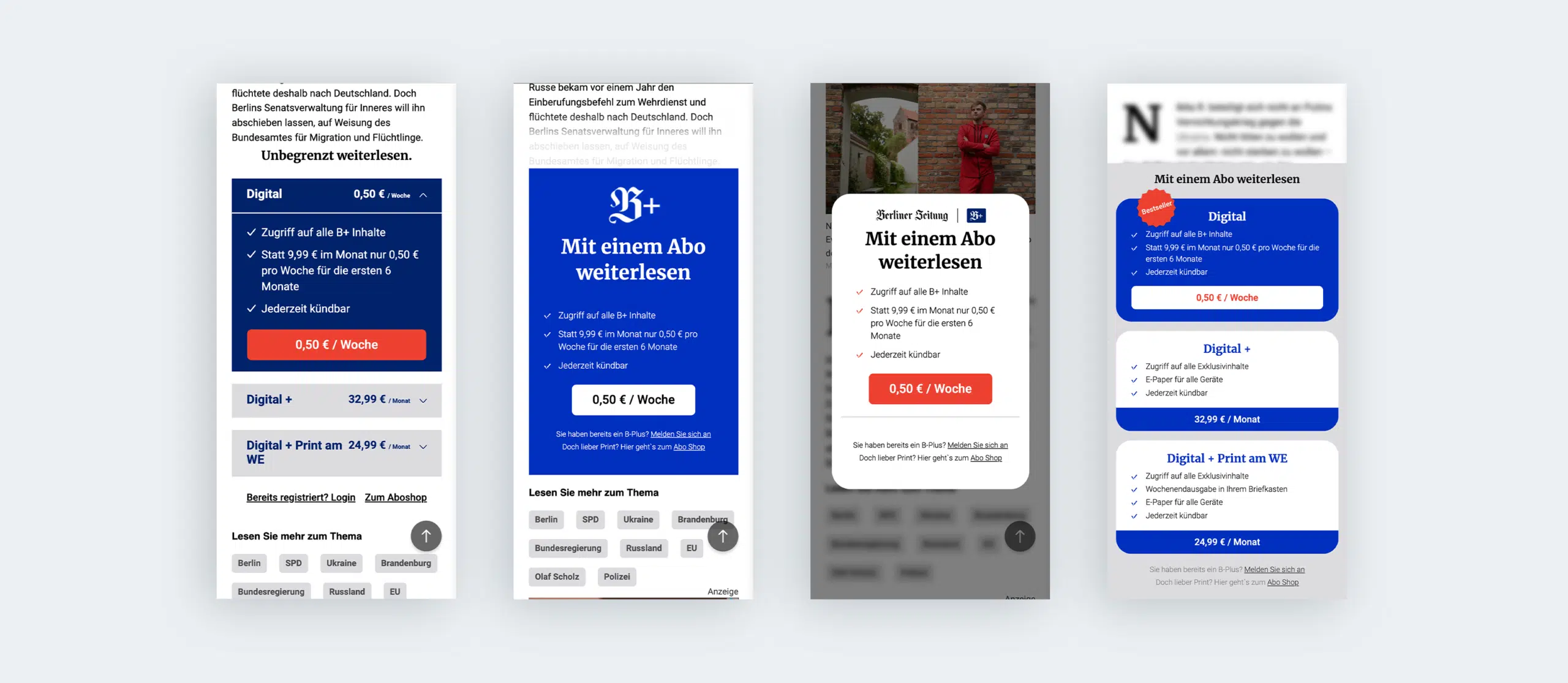

Berliner Zeitung – Mehr Abo-Abschlüsse durch verändertes Paywall-Design

Wer kennt es nicht? Man klickt auf einen Artikel einer Nachrichtenseite und es erscheint ein Pop-up, das darauf hinweist, dass der volle Text nur für Abonnenten verfügbar ist. Die digitalen Angebote von Zeitungen und Magazinen sind auf diese Abo-Zahlungen angewiesen und dementsprechend sind je nach Seite ein guter Teil der Artikel hinter der sogenannten Paywall.

Für die Betreiber der Webseiten stellt sich natürlich die Frage: Wie schaffe ich es, möglichst viele Abonnenten zu gewinnen?

Ein wichtiger Hebel, um die Abo-Rate zu verbessern, ist das Design des Paywall-Hinweises. Die Berliner Zeitung führte zusammen mit der Agentur growganic A/B-Tests, um die Conversion-Rate dieses wichtigen Elements zu verbessern.

A/B-Test bei der Berliner Zeitung. Links die Kontrollvariante, rechts die drei Testvarianten

Das Ergebnis: Die Testvariante zwei mit dem Pop-Up, dem weißen Hintergrund und dem roten Button konnte das beste Ergebnis erzielen.

Insgesamt konnten 333,90% mehr Micro-Conversions und 18,23% mehr digitale Abschlüsse erreicht werden.

Geld-zurück-Garantie ohne nachweisbaren Vorteil, aber dafür mit mehr Aufwand

Geld-zurück-Garantien gelten im E-Commerce häufig als vertrauensbildende Maßnahme. Viele Shops setzen dabei auf großzügige Fristen von 30, 60 oder sogar 100 Tagen. Doch funktioniert das wirklich?

Ein

Onlineshop wollte es genau wissen – und testete die Einführung einer 30-tägigen Geld-zurück-Garantie in einem A/B-Test. Ziel war es herauszufinden, ob dadurch mehr Bestellungen oder ein höherer durchschnittlicher Umsatz pro Nutzer (ARPU) erzielt werden können.

Das Ergebnis:

- Bestellungen: –2,92%

- ARPU: +1,05%

Beide Werte waren statistisch nicht signifikant

Auf den ersten Blick also kein messbarer Effekt – weder positiv noch negativ. Doch bei näherem Hinsehen zeigte sich: Hätte man die Maßnahme flächendeckend eingeführt, wären zusätzliche Belastungen entstanden – etwa durch steigende Retourenquoten oder höheren Aufwand im Customer Service.

Durch den Test konnte der Shop diese Risiken frühzeitig erkennen und wertvolle Ressourcen sparen. Ein gutes Beispiel dafür, wie wichtig es ist, auch scheinbar „sichere“ Maßnahmen zu hinterfragen und datengestützt zu bewerten.

Empfehlenswerte A/B Testing-Softwares

Auf unserer Vergleichsplattform OMR Reviews findest du weitere empfehlenswerte A/B Testing-Softwares.

Wir stellen über 150 Lösungen vor, die optimal für kleine und mittlere Unternehmen, Start-ups sowie Großkonzerne zugeschnitten sind. Diese Softwares bieten umfassende Unterstützung in allen Aspekten des A/B Testings. Nutze diese Chance, die verschiedenen A/B Testing-Tools zu vergleichen und dabei auf echte und verifizierte Nutzerbewertungen zurückzugreifen:

Ich empfehle, A/B-Tests unbedingt mit einem professionellen Tool durchzuführen. Diese Tools helfen beim Erstellen, Durchführen und automatischen Auswerten der Experimente. Bei den meisten Tools sind nicht einmal Programmierkenntnisse nötig.

Für granulare Anpassungen ist es dennoch von Vorteil, wenn du selbst entwickeln kannst oder Developer*innen im Team hast, die dies für dich übernehmen können.

Fazit zum erfolgreichen A/B-Testing

A/B-Testing ist also eine hervorragende Möglichkeit, um mehr über deine Besucher*innen zu erfahren und deine Conversion-Rate datengetrieben zu verbessern. Wie die genannten Beispiele zeigen, gibt es beim A/B-Testen viele Ansatzpunkte. Jetzt hast du genug gelesen: Starte jetzt mit dem A/B-Testing und schreibe deine eigenen Erfolgsgeschichten.

Gastautor*innen Aufruf

Werde Gastautor*in: Du hast tiefgehende Software-Expertise und willst dein Wissen mit der Community teilen? Dann schreibe uns an reviews-experten@omr.com und zeig, was in dir steckt. Wir freuen uns auf praxisnahe Einblicke von echten Profis wie dir.