Inhalt

- Was ist A/B-Testing?

- Welche Arten von A/B-Tests gibt es?

- Was lässt sich mit A/B-Testing erreichen?

- 6 Tipps für erfolgreiches A/B-Testing

- Best Practises erfolgreicher A/B-Tests: So solltest du vorgehen

- Mit welchen Tools lassen sich die Tipps für erfolgreiches A/B-Testing anwenden?

- Fazit

Die Theorie von A/B-Tests klingt simpel: Du vergleichst zwei Varianten von einem Inhalt und die bessere wird zukünftig behalten. Welche Dinge du bei der A/B-Test-Planung unbedingt beachten solltest und wie du deine Conversion-Rate mit zielgerichteten Experimenten nach oben katapultieren lässt, erfährst du in diesem Beitrag.

Was ist A/B-Testing?

A/B-Testing bezeichnet den Vergleich von zwei Varianten eines Systems (zum Beispiel einer Website). Durch das zufällige Ausspielen von Variante A und B soll festgestellt werden, welche Version die bessere Leistung erzielt.

Mithilfe einer statistischen Analyse stellst du nach Erreichen einer bestimmten Stichprobengröße fest, welche dein vorher definiertes Ziel besser erreicht. A/B-Testing ist ein fester Bestandteil bei der Optimierung der Conversion Rate.

Welche Arten von A/B-Tests gibt es?

A/B-Tests werden im Online Marketing nicht nur auf Websites durchgeführt, sondern sind auch bei Werbeanzeigen, App-Inhalten oder E-Mails ein bewährtes Mittel, um die Konvertierungsrate zu steigern. Dieser Artikel fokussiert sich überwiegend auf das Optimieren von Websites, die Tipps und Grundsätze kannst du problemlos auch auf andere Bereiche übertragen.

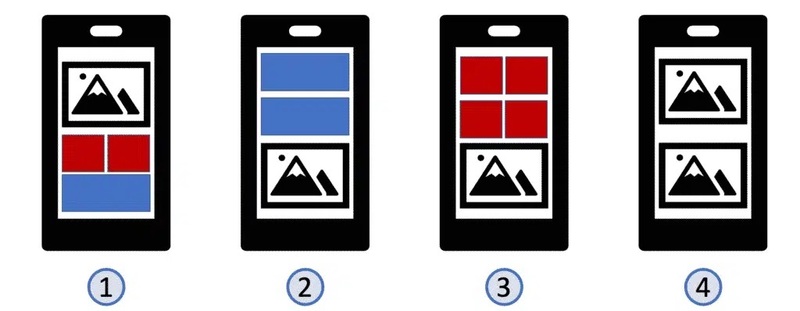

Zudem lassen sich A/B-Tests in drei Kategorien einteilen.

Empfehlenswerte A/B Testing-Softwares

Auf unserer Vergleichsplattform OMR Reviews findest du weitere empfehlenswerte A/B Testing-Softwares.

Wir stellen über 150 Lösungen vor, die optimal für kleine und mittlere Unternehmen, Start-ups sowie Großkonzerne zugeschnitten sind. Diese Softwares bieten umfassende Unterstützung in allen Aspekten des A/B Testings. Nutze diese Chance, die verschiedenen A/B Testing-Tools zu vergleichen und dabei auf echte und verifizierte Nutzerbewertungen zurückzugreifen:

Klassischer A/B-Test

Beim klassischen A/B-Test werden zwei (oder mehr) Varianten einer Seite unter derselben URL getestet. Die Besucher*innen gelangen zufällig auf eine Version geleitet. Wichtig ist, dass nur einzelne Elemente wie Überschriften oder Buttons getestet werden, um gesicherte Erkenntnisse zu gewinnen und genaue Auswirkungen einzelner Veränderungen feststellen zu können.

Weiterleitungstest

Der Weiterleitungstest leitet einen Teil des Traffics an einen oder mehrere andere Inhalte (z.B. eine andere URL) weiter und vergleicht so gesamte Inhalte (wie z.B. Landingpages oder auch ganze Websites) miteinander. Häufig wird der Weiterleitungstest auch Split Test genannt, bei manchen Anbietern bezeichnet der Term Split Test aber auch den standardmäßigen A/B-Test.

Multivariater Test (MVT)

Während beim A/B-Test die Änderungen an genau einem Element getestet werden, ermöglicht multivariates Testing das gleichzeitige Überprüfen von mehreren Änderungen, wie Überschriften, Bildern und Buttons.

Was lässt sich mit A/B-Testing erreichen?

Mithilfe A/B-Testing kannst du nahezu alle Inhalte auf deiner Website testen und optimieren. Typische Beispiele sind:

Titel und Überschriften

Formulierung des Call-to-Actions

Buttons

Bilder

Preise

Formulare

Navigation und Menüs

Seitenstruktur

Doch Veränderung nur um der Veränderung willen, sollte nicht die Motivation hinter deinen A/B-Tests sein. Stattdessen sollte das übergeordnete Ziel immer die

Conversion Optimierung sein. Denn was nützt die schönste oder innovativste Webseite, wenn sie ihre Hauptaufgabe, nämlich die Umwandlung von Besuchern in Kunden, nicht erfüllt? Im Folgenden gehen wir auf die zentralen Ziele der

Conversion Optimierung ein und zeigen, wie A/B-Testing dabei eine Schlüsselrolle spielen kann.

Mehr direkte Umsätze

Du führst einen A/B-Test in deinem Online-Shop durch und findest heraus, dass ein Produktvideo statt einem Produktbild für 20 Prozent mehr Käufe sorgt. Die Konversionsrate hat hier also unmittelbaren Einfluss auf deine Umsätze und sorgt dafür, dass du aus deinen Website-Aufrufen mehr herausholst.

Viele Seitenbetreiber fokussieren sich stark darauf, mit steigenden Ausgaben für bezahlte Werbeanzeigen für mehr Traffic zu sorgen, dabei können bereits einfache Änderungen auf der Website einen viel stärkeren Effekt auf die Umsätze haben.

Mehr Leads

Dein Newsletter ist einer der wichtigsten Verkaufskanäle? Dann bist du verständlicherweise daran interessiert, möglichst viele Abonnenten zu haben. Indem du das

Anmeldeformular für deinen E-Mail-Newsletter regelmäßig per A/B-Testing optimierst, kannst du auch hier ohne steigenden Traffic deine E-Mail-Reichweite vergrößern.

Effizientere Werbeanzeigen

Durch A/B-Testing deiner Online-Werbeanzeigen kannst du herausfinden, welche Botschaften, Bilder oder Call-to-Actions bei deiner Zielgruppe am besten ankommen. Stell dir vor, du investierst in zwei verschiedene Anzeigenvarianten und entdeckst, dass eine Testvariante eine um 30 Prozent höhere Klickrate aufweist. Dies bedeutet nicht nur, dass du für jeden investierten Euro mehr Traffic erhältst, sondern auch, dass das Marketingbudget zielgerichteter und effizienter eingesetzt wird.

Verbesserung der User Experience

A/B-Tests können nicht nur ein hartes Conversion-Ziel, wie etwa weniger Warenkorbabbrüche, haben, sondern auch zur Verbesserung der Nutzerfreundlichkeit eingesetzt werden. Durch verschiedene Experimente kannst du herausfinden, ob ein umgebautes Menü oder ein einfacherer Aufbau die Verweildauer auf deiner Seite erhöht.

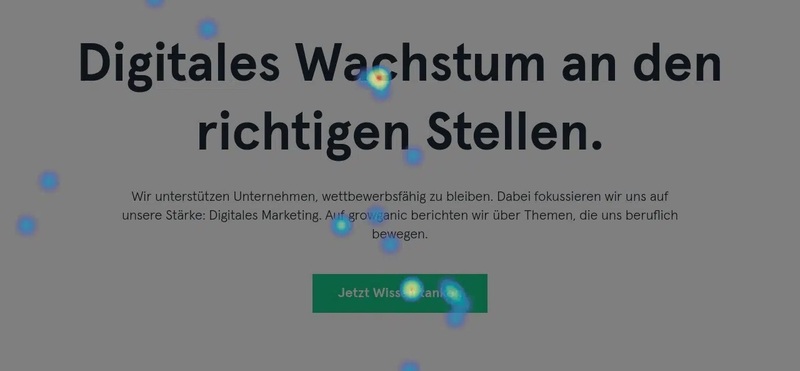

Als Ergänzung zu qualitativen A/B-Tests, wo es immer um die Bestätigung einer Hypothese nach einem ausreichenden Konfidenzniveau geht, kannst du auch User-Experience-Untersuchungen wie die Analyse der Mausbewegungen oder der User Journey in dein Marketing integrieren.

6 Tipps für erfolgreiches A/B-Testing

Damit dein Conversion-Testing (oder auch dein Customer-Experience-Testing) optimal verläuft, geben wir dir hier 6 Tipps für die Planung und Durchführung von erfolgreichen A/B-Tests.

1. Priorisiere die Tests richtig

Die Möglichkeiten für A/B-Testing sind riesig. Buttons, Überschriften, Bilder, Menüs oder Farben – bei der Fülle geht schnell die Übersicht verloren. So verlockend es auch sein mag, schnell einen einfachen Test für die Hintergrundfarbe deiner Startseite aufzusetzen: Hilft dir dieser Test wirklich bei deinen Zielen weiter? Oder solltest du dich lieber zunächst darauf fokussieren, einen messerscharfen und überzeugenden Call-to-Action zu formulieren?

Nicht alle Änderungen haben den gleichen Einfluss auf die

Conversion-Rate. Bevor du mit dem Testen beginnst, solltest du dir überlegen, welche Änderungen wohl den größten Einfluss auf deine Besucher*innen und deren Verhalten haben. Setze also klare Prioriäten und richte deinen Fokus auf die Tests, die den größten Mehrwert bieten.

2. Teste nur eine Änderung gleichzeitig

Beim A/B-Testing solltest du außerdem einem weiteren Drang widerstehen: Sofort mehrere Änderungen gleichzeitig zu testen, um schneller Ergebnisse zu sehen. Das Testen mehrerer Elemente auf einmal kann aber die Ergebnisse verfälschen. Ist der erhöhte durchschnittliche Warenkorbwert pro Besucher auf die prominenter platzierten Produktbeschreibungen oder auf den neu eingeführten Chatbot für das Beantworten von Fragen zurückzuführen?

Ja, komplexere Szenarien wie multivariate Tests oder Multi-Page-Experimente haben ihre Berechtigung, aber versuche dich, insbesondere wenn du noch am Anfang der Optimierung stehst, auf eine getestete Änderung zu beschränken.

Ein sorgfältig durchgeführter Test mit eindeutigen Ergebnissen ist viel wertvoller als mehrere gleichzeitige Experimente mit schwer interpretierbaren Resultaten.

3. Setze die Tests statistisch sauber auf

Das Herzstück erfolgreicher A/B-Tests ist eine klare Zielsetzung und ein sauberes statistisches Aufbereiten. Überlege dir, welches Ziel du erreichen willst, und formuliere davon ausgehend eine Hypothese. Anschließend setzt du die Änderungen in deinem A/B-Testing-Tool um und testest so lange, bis die Stichprobe groß genug ist und eine statistische Signifikanz erreicht ist. Die meisten Tools helfen dir beim Aufsetzen und benachrichtigen dich, wenn aussagekräftige Ergebnisse vorliegen.

4. Nutze Segmentierung

Website-Besucher*innen können in ihrem Nutzerverhalten starke Unterschiede aufweisen. Aus diesem Grund kann es sinnvoll sein, dich bei Tests auf einzelne Nutzergruppen zu beschränken (zum Beispiel Smartphone-User, Frauen oder Besucher*innen, die über die Google-Suche auf die Seite kamen).

Indem du Tests auf bestimmte Segmente ausrichtest, kannst du viel tiefere und nuanciertere Einblicke gewinnen und maßgeschneiderte Erfahrungen für verschiedene Gruppen bereitzustellen.

Auch hier gilt: Verkompliziere das Testen nicht! Bringt es dich deinen Umsatzzielen näher, wenn du testest, wie weibliche Besucherinnen über 45 mit einem Apple Smartphone aus Niedersachsen auf eine alternative Überschrift reagieren? Ganz zu schweigen davon, dass derartige Tests wohl sehr lange laufen müssen, um eine ausreichend große Fallzahl zu erreichen.

5. Berücksichtige externe Faktoren

Bei all den Vorteilen, die ein datengetriebenes Marketing mit effektivem A/B-Testing hat: Manchmal können externe Faktoren Ergebnisse verfälschen und zu falschen Schlussfolgerungen führen.

Feiertage, Jahreszeiten, aktuelle Ereignisse oder auch andere Marketingkampagnen von dir können das Verhalten deiner Nutzer*innen verändern und somit das Ergebnis verzerren. Ein typisches Beispiel: Am Anfang des Monats können viele Online-Shops eine dramatisch gestiegene Conversion-Rate verzeichnen. Dafür ist aber in der Regel nicht das grandiose neue Shop-Design verantwortlich, sondern schlicht die Tatsache, dass es sich mit einem frisch vom Lohn aufgefüllten Bankkonto einfach leichter einkauft.

Prüfe deshalb bei der Auswertung deiner Tests immer, ob es externe Einflüsse während des Testzeitraums gab und diese möglicherweise die Ergebnisse beeinflusst haben. Gegebenenfalls kannst du den Test dann später wiederholen, um sicherzustellen, dass die Resultate tatsächlich auf die Änderungen und nicht auf externe Einflüsse zurückzuführen sind.

6. Vernachlässige Auswertung und Dokumentation nicht

Für viele Marketeers ist der A/B-Test beendet, sobald das Tool auf "grün" schaltet und die Änderungen bestätigt werden. Anschließend werden diese umgesetzt und das nächste Experiment wird ausgerollt. Eine gründliche Auswertung und Dokumentation der Testergebnisse sind jedoch entscheidend, damit du langfristig von deinen gewonnenen Erkenntnissen profitierst.

Eine detaillierte Analyse zeigt dir möglicherweise nicht nur, welche Änderungen erfolgreich war, sondern auch den Grund dafür. Teile die Ergebnisse unbedingt auch mit den anderen Teams, damit diese Dinge bei der Erstellung künftiger Inhalte berücksichtigt werden.

Nicht selten lassen sich A/B-Tests auch vermeiden, weil bereits in der Vergangenheit ein vergleichbares Experiment durchgeführt wurde, das schon in Vergessenheit geraten ist. Eine saubere Dokumentation sorgt für eine deutlich effizientere Nutzung deiner Testressourcen.

Best Practises erfolgreicher A/B-Tests: So solltest du vorgehen

Für die Durchführung von erfolgreichen A/B-Tests hat sich die folgende Vorgehensweise bewährt.

1. Überlege, was du testen willst

Überlege dir im ersten, Schritt, welches Element du testen und verbessern willst. Soll es um die Betreffzeilen deines nächsten Newsletters gehen? Oder möchtest du dein Formular zur Kontaktaufnahme anpassen? Du solltest zudem auch schon im Hinterkopf haben, welches Ziel du erreichen willst (beispielsweise eine bessere Öffnungsrate oder eine höhere Conversion-Rate für Kontaktanfragen).

2. Hypothese aufstellen

Anschließend formulierst du eine saubere Hypothese. Beispielsweise könnte sie so aussehen:

"Wenn ich ein Emoji in den Betreff der Newsletter-E-Mail einfüge, dann erhöht sich die Öffnungsrate, weil Nutzer*innen durch die auffälligere Darstellung auf die Nachricht besser wahrnehmen."

3. Test technisch sauber aufsetzen

In deinem A/B-Testing-Tool setzt du nun den Test auf, kreierst Variante B und überprüfst noch einmal, ob du die Parameter wie Laufzeit, Konfidenzniveau richtig eingestellt hast. Bei einem Test auf der Website stellst du am besten in einem privaten Browserfenster noch einmal sicher, dass auch beide Varianten ausgespielt werden.

4. Ergebnis auswerten

Ist der Test abgeschlossen, solltest du nicht Hals über Kopf die erfolgreichere Variante umsetzen. Überlege dir noch einmal, ob die Ergebnisse wirklich aussagekräftig und auf die Veränderungen zurückzuführen sind.

Wir empfehlen dir, A/B-Tests unbedingt mit einem professionellen Tool durchzuführen. Diese Tools helfen dir beim Erstellen, Durchführen und Auswerten von Experimenten. Bei den meisten Tools benötigst du nicht einmal Programmierkenntnisse, dennoch ist es enorm von Vorteil, wenn du selber entwickeln kannst oder einen Developer im Team hast, der dies für dich übernehmen kann.

Hier eine kleine Auswahl an Tools für dein A/B-Testing:

Fazit

A/B-Testing ist ein sehr guter Weg, um mehr über deine Kund*innen zu lernen und deine Conversion-Rate zu verbessern. Wenn du die erwähnten Tipps umsetzt, steht einem erfolgreichen A/B-Testing nichts mehr im Wege.

ABlyft

ABlyft Kameleoon

Kameleoon Varify.io

Varify.io trbo

trbo EASY2

EASY2 Dynamic Yield

Dynamic Yield NOSTO

NOSTO