Was bedeutet Indexierung?

Wir erklären Euch, was eine Indexierung in Suchmaschinen ist und worauf Ihr dabei achten solltet

Bei der Indexierung handelt es sich um das Aufnehmen von Webseiten in ein geordnetes Register bzw. Verzeichnis, dem Index. D.h. nur die Webseiten, die von Google indexiert wurden, können über die Suchmaschine durch Nutzer*innen auch gefunden werden. Das Thema der Indexierung ist für Suchmaschinen demnach ein elementarer Bestandteil für Euch.

Der Index von Suchmaschinen ist deutlich komplexer als herkömmliche Verzeichnisse. Wir haben es mit keiner einfachen alphabetischen oder chronologischen Übersicht zu tun, sondern mit einer Vielzahl von unterschiedlichen Kriterien. Google versucht grundsätzlich alles zu indexieren, was sich auffinden lässt. Dies geschieht mit Hilfe sogenannter Crawler. Hierbei gibt es nur zwei Einschränkungen:

- Websiten-Betreiber*innen möchten nicht, dass die eigene Website indexiert wird

- Die Website entspricht nicht den Google Richtlinien

Unser Gastautor Alex Wolf zeigt, warum eine Indexierung so wichtig für Euch ist und in welchen Schritten Ihr herausfindet, ob Eure Website indexiert ist.

Warum eine Indexierung wichtig ist

Eine Suchmaschine lebt von zwei Eigenschaften:

- einem umfangreichen Index an Websites

- einem klugen Algorithmus, um die besten Ergebnisse aus dem Index zu einer Suchanfrage zu liefern

Zweites klappt nur erfolgreich, wenn auch passende und aktuelle Seiten im Index zu finden sind. Gerade bei Nachrichten spielt die Aktualität eine besonders große Rolle. Nur wenn Suchmaschinen genug Futter haben, anhand dessen der Algorithmus lernen kann, können gute Suchergebnisse ausgegeben werden.

Wie Ihr herausfindet, ob Eure Website indexiert ist

Google bietet Euch zwei schnelle und simple Wege an, um herauszufinden, ob Websites indexiert sind oder nicht. Eine site:-Abfrage und die Überprüfung über die Google Search Console.

Im nächsten Schritt erklären wir Euch genauer, wie Ihr mit diesen beiden Wegen arbeitet.

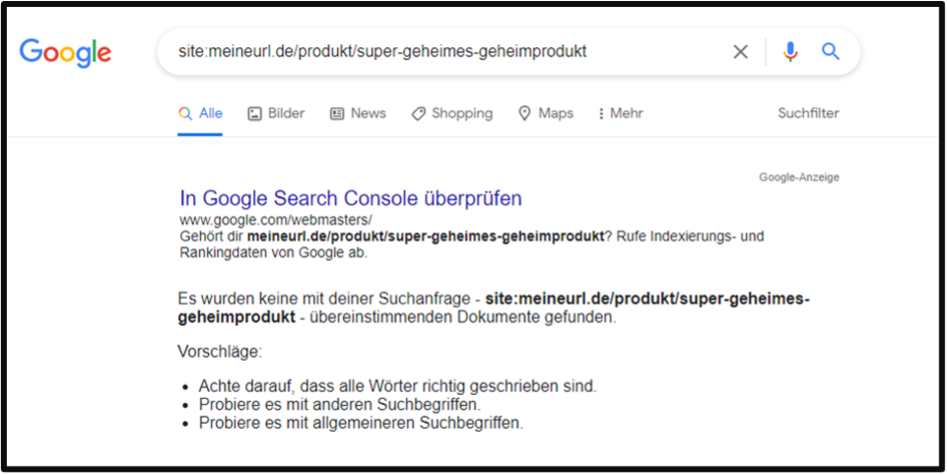

1. Weg: Überprüfung mit einer site:-Abfrage

Die site:-Abfrage funktioniert wie eine normale Suche über die Google Suchmaschine. Die Suche wird lediglich um einen Parameter ergänzt und dadurch stark eingeschränkt, um genau das Ergebnis zu bekommen, nach dem man sucht.

Um zu überprüfen, ob die Webseite meineurl.de/produkte/super-geheimes-geheimprodukt indexiert ist, könnt Ihr natürlich nach „meineurl super geheimes geheimprodukt“ suchen. Der Nachteil dieser Suchanfrage ist, dass keine Eingrenzung vorgenommen wurde. Es werden Euch alle Ergebnisse ausgegeben, die zu dieser Suchanfragen passen. Mit dem vorangestellten Parameter „site:“ wird tatsächlich nur nach der darauffolgenden Webseite gesucht.

Mit der Abfrage nach „site:“ gefolgt von der URL sucht Ihr ausschließlich nach der URL im Index.

Die site:-Abfrage lässt sich noch um weitere Suchkriterien ergänzen.

- site:meineurl.de Schuhe: Liefert alle Unterseiten, die den Begriff „Schuhe“ beinhalten.

- site:meineurl.de intitle: Schuhe: Lieferte alle Unterseiten, die „Schuhe“ im Titel stehen haben.

- site:meineurl.de filetype:docx: Liefert alle .docx-Dateien einer Website aus dem Index. Das funktioniert natürlich auch mit anderen Dateitypen.

- site:meineurl.de inurl:hose: Liefert alle Ergebnisse unserer Webseite mit „hose“ in der URL.

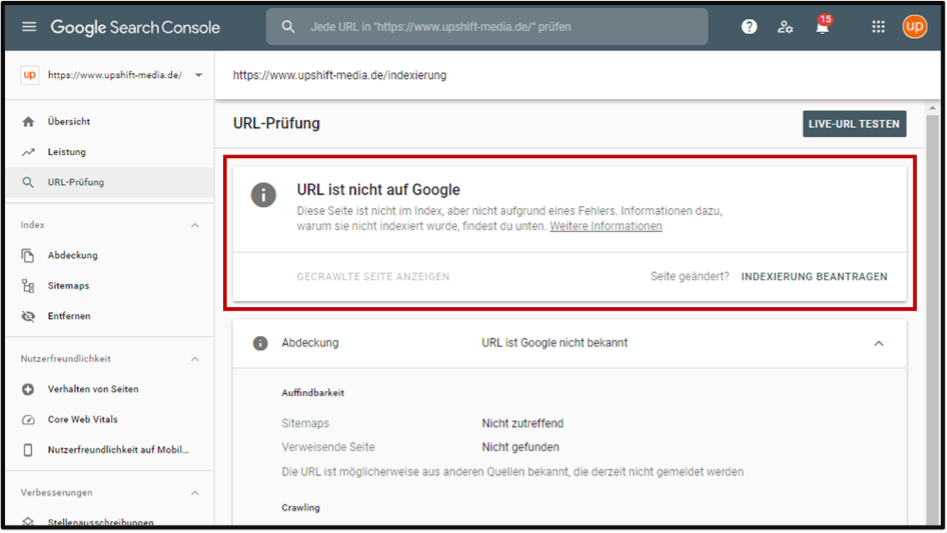

2. Weg: Überprüfung mittels Google Search Console

Die Google Search Console liefert einen kompletten Status über den Stand der Indexierung. Die Überprüfung mit der Google Search Console setzt jedoch voraus, dass Eure eigene Website dort hinterlegt und verifiziert ist.

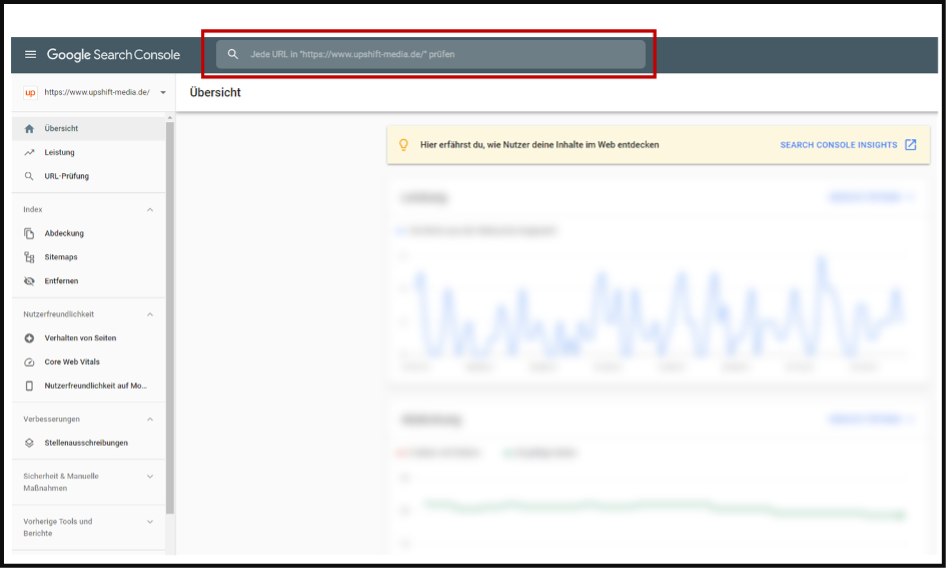

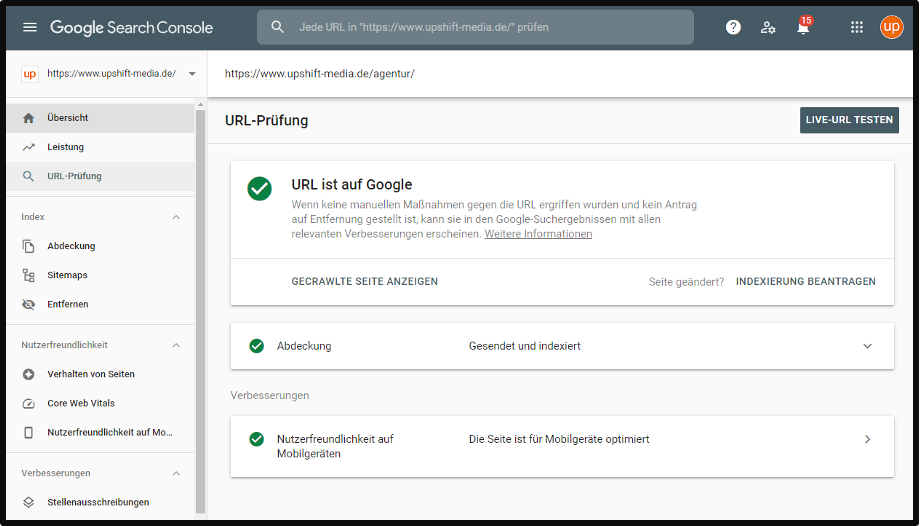

Durch die Eingabe der URL in das Suchfeld innerhalb der Google Search Console könnt Ihr den aktuellen Stand der Indexierung abfragen.

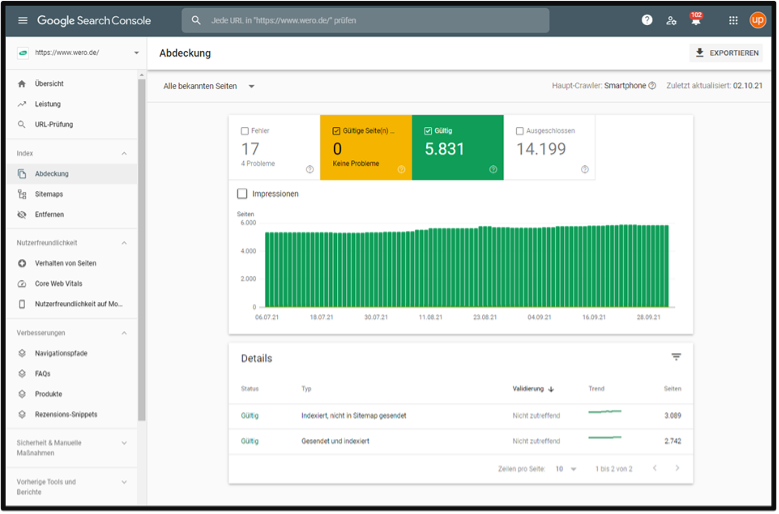

Um den Indexierungsstand der gesamten Website zu prüfen, gibt es den Bereich „Abdeckung“.

Im Bereich „Abdeckung“ der Google Search Console sehen wir die indexierten Seiten sowie die Seiten, die wir von der Indexierung ausschließen. Die indexierten Seiten teilen sich in zwei Status in der Google Search Console:

- Gültige Seite(n) mit Warnungen: Die erscheinen zwar im Index der Suchmaschinen, es gibt jedoch Unstimmigkeiten für die Suchmaschine. Unstimmigkeiten können beispielsweise dadurch entstehen, dass die indexierte Seite nicht in der Sitemap auftaucht oder wenn ein Crawlen der Seite mittels robots.txt unterbunden wurde.

- Gültig: Unter gültige Seiten fallen alle regulären Seiten, die ohne Fehler oder Unstimmigkeiten indexiert werden konnten.

Wie können Websites von Suchmaschinen indexiert werden?

Seiten können auf zwei Arten indexiert werden – über einen passiven oder einen aktiven Weg. Beide Ansätze werden offiziell von Google unterstützt, jedoch gibt es natürlich keine Garantie für die Indexierung.

Der passive Ansatz

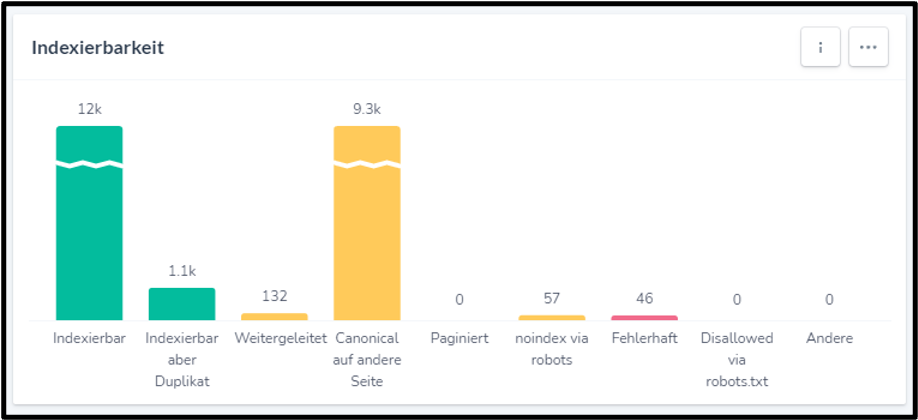

Für den passiven Ansatz müsst Ihr als Website-Betreiber*in keine eigenen Maßnahmen ergreifen. Google versucht, die Website zu finden und zu indexieren. Voraussetzung hierfür ist, dass die Website nicht für Crawler blockiert wird und im besten Fall eingehende Verlinkungen von intern oder extern hat. Ob die Website lesbar für Crawler ist sowie den Status der Indexierung, könnt Ihr auch mit dem SEO-Tool Ryte auslesen.

Bei Ryte erhaltet Ihr eine komplette Übersicht über die Crawlability sowie den Indexierungsstand der gesamten Website.

Der passive Ansatz kann zu Problemen führen, wenn nur wenig oder keine eingehenden Verlinkungen zur Website vorhanden sind. Zudem kann es sein, dass Inhalte deutlich verzögert indexiert werden.

Der aktive Ansatz

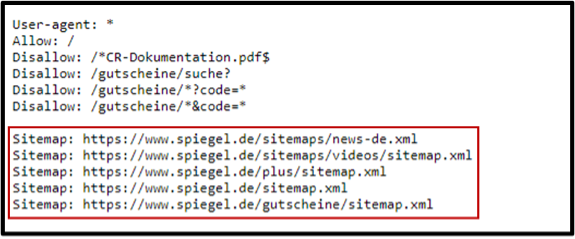

Beim aktiven Ansatz wird der Suchmaschine eine Liste mit URLs, eine sogenannte Sitemap, zur Verfügung gestellt. In der Regel wird die Sitemap an einem Ort auf der Domain gehostet, auf den Suchmaschinen zugreifen können. Zusätzlich lässt sich der Speicherort der Sitemap in der robots.txt Datei angeben.

Mithilfe der Sitemap können Suchmaschinen Änderungen an der Website schneller erkennen, da die Sitemap zusätzlich einen Zeitstempel mit dem Datum und der Uhrzeit der letzten Änderung hat.

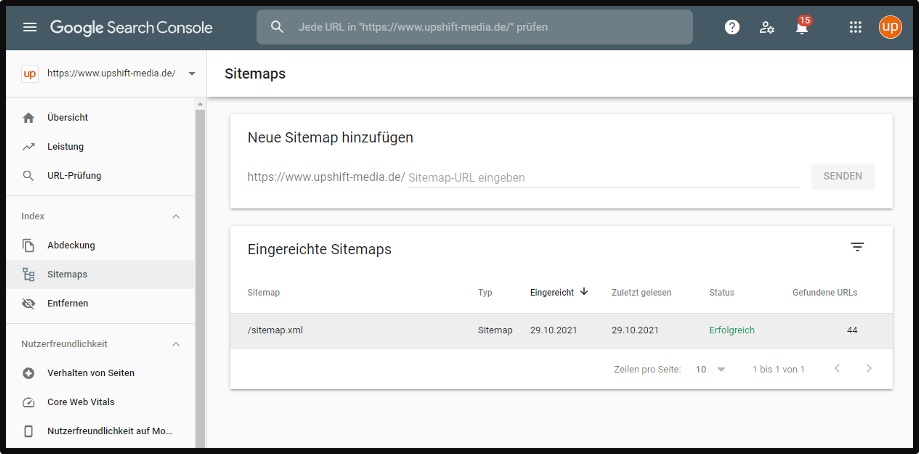

Zusätzlich kann die Sitemap auch über die Google Search Console eingereicht werden. Hierzu wird im linken Menü der Punkt „Sitemaps“ ausgewählt und dort der Pfad zur Sitemap angegeben. Selbstverständlich könnt Ihr auch mehrere Sitemaps, für bspw. unterschiedliche Sprachen, einreichen.

Sitemap über die Google Search Console einreichen

Ihr könnt in der Google Search Console aber auch für einzelne URLs / einzelne Webseiten überprüfen, ob diese bereits bei Google indexiert sind. Dazu gebt Ihr die zu untersuchende URL entweder in das obere Suchfeld ein oder klickt in Seitenmenü auf „URL-Prüfung“ und gebt dann die URL ein. Google prüft zunächst den Indexierungsstatus und bietet Euch anschließend die Möglichkeit, die Indexierung zu beantragen (sofern noch nicht geschehen).

Allgemein ist die Chance einer zeitnahen Indexierung beim aktiven Ansatz höher als bei dem passiven Ansatz.

Wie lange dauert eine Indexierung?

Um es mit den Worten von John Müller (Webmaster Trends Analyst bei Google) zu sagen: „It depends.“. Die Zeit, bis eine Website indexiert wird, hängt davon ab, wie häufig die Website gecrawlt wird, wie häufig es auf der Website Änderungen gibt und wie die Lesbarkeit für Suchmaschinen ist.

Im ersten Schritt wird die Website lediglich gecrawlt. Das kann binnen weniger Tage passieren. Anschließend werden die gecrawlten Inhalte indexiert. Bei diesem Vorgang können tatsächlich sogar einige Wochen ins Land gehen. Damit dann noch Eure Webseiten auf der ersten Seite bei Google angezeigt werden, bedarfs es einer guten Suchmaschinenoptimierung (SEO), viel Arbeit, Fleiß und Geduld.

Lässt sich die Indexierung beschleunigen?

Long story short: Die Indexierung lässt sich nicht beschleunigen. Zwar gibt es die Möglichkeit, in der Sitemap den einzelnen URLs eine Priorität zu geben, diese wird jedoch seitens Google nicht mehr verarbeitet. Auch das mehrfache Einreichen über die Google Search Console beschleunigt den Prozess der Indexierung nicht. Es hilft tatsächlich nur Geduld.

Wie kann ich Webseiten deindexieren?

Es gibt mehrere Methoden, bereits indexierte Websites deindexieren zu lassen. Zum einen lässt sich dies über die robots-Meta-Angaben auf der Website realisieren. Durch die Angabe <meta name=“robots“ content=“noindex“> wird die Website entweder erst gar nicht in den Index aufgenommen oder beim erneuten Crawlen deindexiert.

Sollte eine Webseite nicht mehr verfügbar sein und diese dadurch entweder eine 404 Meldung ausgeben oder via 301 / 302 weiterleiten, wird die entsprechende Webseite nach einer Weile automatisch deindexiert.

Wichtig: Die Aufnahme einer Webseite in die robot.txt führt nicht dazu, dass die Webseite aus dem Index verschwindet oder gar nicht erst indexiert wird. Das hat lediglich zur Folge, dass die Webseite nicht gecrawlt wird. Durch eingehende Verlinkungen kann die Webseite dennoch indexiert werden. Ein Ausschluss des Crawlers bedeutet nicht, dass eine Webseite nicht indexiert wird.

Troubleshooting: Meine Webseite erscheint nicht im Index

Wenn Ihr Eure eigenen Webseiten nicht über die Suchmaschine finden könnt, kann das unterschiedliche Gründe haben. Um schnell auszuschließen, dass das Problem an der Webseite selbst liegt, haben wir eine Checkliste mit wichtigen Fragen für Euch parat:

1. Ist die Website über die URL von außen erreichbar?

Prüft mit verschiedenen Endgeräten, ob die Webseite auch außerhalb Eures eigenen Netzwerks erreichbar ist. Gibt die Webseite vielleicht einen 404-Statuscode zurück?

2. Ist eine Weiterleitung aktiv?

Prüft, ob es eine aktive 301- oder 302-Weiterleitung gibt und entfernt diese.

3. Prüfe die Meta-Robots-Angaben Eurer Websites

Sollte die Anweisung „noindex“ oder „none“ in den Meta-Robots-Tags auftauchen, wird die Indexierung unterbunden.

4. Zeigt ein kanonisches Tag auf eine andere Webseite?

Ein kanonisches Tag, auch Canonical Tag, zeigt in der Regel auf den ursprünglichen Inhalt einer Webseite. Die Anweisung hilft Suchmaschinen mit Duplicate Content umzugehen.

5. Wird das Crawlen durch die robots.txt unterbunden?

Wenn die Webseite oder das Verzeichnis nicht gecrawlt werden darf, wird die Indexierung deutlich erschwert und kann sich dadurch verzögern oder auch gar nicht stattfinden.

Tools, wie bspw. Screaming Frog SEO Spider, liefern Euch u. a. einen schnellen Überblick über die hinterlegten Weiterleitungen und Meta-Angaben sowie die Erreichbarkeit der Webseite.

Empfehlenswerte SEO Tools

Weitere empfehlenswerte SEO-Tools kannst du auf OMR Reviews finden und vergleichen. Insgesamt haben wir dort über 150 SEO-Tools (Stand: Dezember 2023) gelistet, die dir dabei helfen können, deinen organischen Traffic langfristig zu steigern. Also schau vorbei und vergleiche die Softwares mithilfe der verifizierten Nutzerbewertungen: