Inhalt

- Was ist RAG (Retrieval Augmented Generation)?

- Welche Vorteile bietet Retrieval Augmented Generation?

- Retrieval-Augmented Generation und semantische Suche

- Was ist eine semantische Suche?

- Wie kann RAG deine Kundenkommunikation unterstützen?

- Wie kannst du RAG in bestehende Systeme integrieren?

- Diese RAG-Tools könnten deinen Prozess unterstützen

- Fazit und Ausblick

Das Wichtigste in Kürze

- RAG (Retrieval-Augmented Generation) erweitert Large Language Models (LLMs) mit externen, geprüften Wissensquellen, um Halluzinationen zu reduzieren und Antworten aktuell sowie inhaltlich korrekt zu machen.

- Die semantische Suche ist oft ein zentraler Bestandteil von RAG, da sie die Absicht hinter einer Suchanfrage versteht und relevante Inhalte findet, auch wenn die Schlüsselwörter nicht exakt übereinstimmen.

- Durch die Nutzung von RAG können Unternehmen ihre automatisierte Kundenkommunikation in Bereichen wie Produktberatung und komplexem Support präziser, sicherer und konsistenter gestalten, wodurch sie skalierbar wird.

Retrieval Augmented Generation (RAG) – klingt erstmal etwas kompliziert. Aber bevor nun der Tab direkt wieder geschlossen wird: Retrieval Augmented Generation ist meiner Ansicht nach eine der wichtigsten Technologien für die automatisierte Kundenkommunikation. Denn erst mit RAG, ist es möglich, Large Language Models (LLMs) und generative KI gezielt und sinnvoll insbesondere in der Kundenkommunikation einzusetzen. Warum das so ist? Das möchte ich dir in dem folgenden Artikel erklären.

Was ist RAG (Retrieval Augmented Generation)?

Retrieval Augmented Generation – kurz RAG – ist im Grunde eine Art Brücke zwischen großen Sprachmodellen und externen Quellen, wie z. B. einer Datenbank mit Produkten und ihren Spezifikationen.

Während klassische KI-Modelle wie das hinter ChatGPT nur das nutzen, was sie einmal beim Training gelernt haben (zumindest im Basismodell), ergänzt RAG dieses Wissen um Informationen, die für das Training entweder nicht verfügbar waren oder deren Relevanz sich erst im Kontext der Anfrage zeigt – etwa durch die Seite, auf der sich der Chatbot befindet, oder den konkreten Gesprächsverlauf. Das bedeutet: Ein Chatbot mit RAG kann nicht nur „allgemein schlaue“ Antworten geben, sondern beispielsweise auf Produktdaten, interne Dokumente oder FAQs zugreifen.

Ich sehe RAG daher als eine Art Gedächtniserweiterung für KI-Systeme. Statt sich ausschließlich auf das zu verlassen, was das Modell irgendwann gelernt hat, greift RAG oder auch RAG AI im Hintergrund auf eine Wissensquelle zu.

Auf Deutsch bedeutet Retrieval-Augmented Generation: Generieren, ergänzt durch Abrufen. Genau das beschreibt auch die zwei zentralen Schritte des Prozesses:

- Retrieval (Abrufen): Das System sucht mithilfe der semantischen Suche, Knowledge Graphs oder Stichworten nach relevanten Informationen – zum Beispiel in einer internen Wissensdatenbank, Produktdokumentation oder FAQ.

- Generation (Erzeugen): Die gefundenen Informationen werden an das Sprachmodell übergeben, das daraus eine verständliche, zusammenhängende Antwort formuliert.

So entsteht eine Kombination aus aktuellem Wissen und sprachlicher Intelligenz.

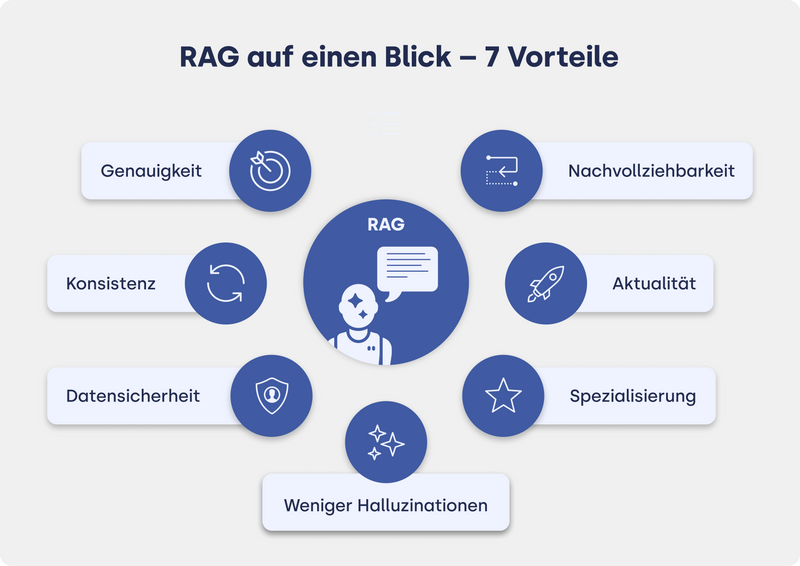

Welche Vorteile bietet Retrieval Augmented Generation?

Kurz gesagt: RAG hilft dabei, Antworten nicht nur sprachlich überzeugend, sondern auch inhaltlich korrekt und aktuell zu gestalten, und es reduziert Halluzinationen deutlich, weil die KI auf geprüfte Informationen zurückgreift.

Die wichtigsten Vorteile auf einen Blick:

- Höhere Genauigkeit: RAG nutzt geprüfte Unternehmensdaten, statt sich allein auf das Modellwissen zu verlassen.

- Aktualität: Neue oder geänderte Informationen stehen sofort zur Verfügung, ohne aufwändiges Finetuning.

- Spezialisierung auf Fachgebiete: Durch die Verbindung mit einer spezialisierten Wissensdatenbank kann ein Large Language Model auch auf Fachfragen reagieren, etwa in heiklen Bereichen wie Medizin oder Recht.

- Bessere Datensicherheit: Sensible Daten bleiben außerhalb des Modells gespeichert. So können vertrauliche Informationen sicher genutzt werden, ohne dass sie in das LLM selbst einfließen.

- Bessere Nachvollziehbarkeit: Quellen können transparent angegeben oder dokumentiert werden, was die Qualitätssicherung erleichtert.

- Konsistenz in der Kommunikation: Alle Nutzer*innen erhalten dieselben, verlässlichen Informationen, ganz gleich wie die Frage formuliert wird. Gleichzeitig kann auch der gewünschte Blickwinkel des Unternehmens eingehalten werden, etwa eine klare Positionierung oder die Fokussierung auf bestimmte Produkte.

- Weniger Halluzinationen: Das Modell greift auf relevante und gezielt ausgewählte Informationen zu, statt Antworten auszurechnen oder zu „erfinden“.

- Einfache Implementierung: Im Vergleich zum kompletten Umtrainieren eines Modells lässt sich RAG schneller umsetzen. „Einfach“ heißt hier aber nicht trivial – es braucht nach wie vor Know-how, um eine stabile und verlässliche Lösung zu entwickeln. In vielen Fällen sind daher spezialisierte Systeme und Expert*innen empfehlenswert.

Was ist ein LLM?

Die drei Buchstaben stehen für Large Language Model. Seit dem Release von ChatGPT im Jahr 2022 sind LLMs auch außerhalb der Tech-Welt bekannt – und das aus gutem Grund: Ein Large Language Model ist ein spezielles maschinelles Lernmodell, das darauf trainiert wird, menschliche Sprache zu verstehen, zu verarbeiten und selbst zu generieren. Solche Modelle bestehen aus Milliarden von Parametern und machen das Modell somit „large“. Diese enorme Datenmenge ermöglicht es, sprachliche Muster, Grammatik, Bedeutungen und sogar Stile zu erkennen. Bekannte Beispiele für LLMs sind die Modelle von OpenAI wie GPT-5. Sicherlich hast du auch schon von Gemini aus dem Hause Google oder von Mistral gehört.

Trainiert werden LLMs mit riesigen Textmengen aus dem Internet, aus Büchern, Artikeln oder anderen Quellen. Dadurch lernen sie, nahezu wie Menschen zu kommunizieren. Dies erfolgt jedoch – und das ist sehr wichtig – ohne echtes Verständnis, sondern durch Mustererkennung. Du kannst also bei der Nutzung von einem LLM wie GPT-5 nicht davon ausgehen, dass das Modell tatsächlich versteht, was du meinst oder was die eigene Antwort bedeutet. Vielmehr berechnet es die wahrscheinlichste Fortsetzung des Satzes, also das Wort, das mit höchster Wahrscheinlichkeit als Nächstes folgt. Diese Berechnung basiert auf statistischen Zusammenhängen, nicht auf echtem Wissen oder Bewusstsein.

Ein LLM „weiß“ also nichts, sondern simuliert Verständnis durch Muster in den Daten. Genau deshalb entstehen auch sogenannte Halluzinationen: plausible, aber falsche Antworten. RAG löst genau das, indem das Modell auf echte Informationen zugreift.

Retrieval-Augmented Generation und semantische Suche

Um die relevanten Informationen zu finden, ist die sogenannte semantische Suche häufig ein Teil von RAG. Ich nutze hier den Begriff häufig, da nicht immer die semantische Suche, sondern unter anderem auch Knowledge Graphs, auf Deutsch Wissensgraph, für die Suche genutzt werden. In diesem Artikel betrachten wir jedoch die semantische Suche genauer.

Was ist eine semantische Suche?

Die semantische Suche ist eine Technik, die die kontextuelle Bedeutung und die Absicht hinter einer Suchanfrage versteht. So werden nicht einfach nur einzelne Worte abgeglichen, vielmehr wird die Beziehung zwischen Worten ermittelt, sodass korrekte Textpassagen zu einer Suchanfrage gefunden werden, auch wenn die Suchanfrage das etwaige Schlüsselwort oder den korrekten Begriff nicht enthält. Damit dies gelingt, werden Künstliche Intelligenz, Machine Learning und auch die Suche nach passendem Wissen mithilfe von Vektoren, die die Semantik der Texte widerspiegeln, eingesetzt.

Bei der semantischen Suche werden Worte, Sätze oder ganze Texte in Vektoren umgewandelt – man spricht hier vom Embedding, zu deutsch Einbettung, weil die Texte mit ihrer Bedeutung in einem Vektorraum repräsentiert sind.

Stark vereinfacht kann man sich das so vorstellen: Ein Vektor besteht aus einer festen Anzahl von Zahlen. Jede Position in dieser Zahlenfolge steht – sehr abstrakt – dafür, wie stark ein Text eine bestimmte Eigenschaft aufweist. Als anschauliches Beispiel: Eine der Positionen könnte widerspiegeln, wie stark ein Text etwas mit Freizeitbeschäftigungen zu tun hat (auch wenn es in der Realität natürlich viel komplexer und nicht so eindeutig ist). Die „räumliche Nähe“ von Vektoren wird während des Trainings des Embedding-Modells so optimiert, dass Textstücke, die oft in ähnlichen Bedeutungszusammenhängen vorkommen, im Vektorraum näher beieinander liegen. Ähnliche Inhalte haben also ähnliche Vektoren, weniger ähnliche Inhalte liegen weiter auseinander.

Wenn du also eine Frage stellst, wird auch diese als Vektor dargestellt und dann mit allen gespeicherten Vektoren verglichen. Die KI sucht also nicht nach identischen Wörtern, sondern nach ähnlichen Bedeutungen. Dadurch findet sie auch passende Informationen, wenn du dich anders ausdrückst als im ursprünglichen Text.

Wenn du zum Beispiel schreibst: „Wie kann ich meine Bestellung stornieren?“, findet die semantische Suche dann auch Textabschnitte wie: „(...) wenn du deine Bestellung rückgängig machen willst“ oder „Der Wegweiser zur Stornierung (...)“ obwohl die Worte nicht zwingend übereinstimmen. Das liegt daran, dass alle drei Sätze im Vektorraum nah beieinander liegen – sie drücken denselben Sinn aus.

Im Zusammenhang mit RAG spielt die semantische Suche eine wichtige Rolle, denn sie sorgt dafür, dass die relevanten Informationen überhaupt gefunden werden. Wenn eine Nutzeranfrage eingeht, durchsucht die KI mithilfe der semantischen Suche den vorhandenen Wissensspeicher. Erst danach greift der zweite Teil von RAG: das Generieren einer Antwort auf Basis der gefundenen Inhalte.

Wie kann RAG deine Kundenkommunikation unterstützen?

Auf Basis des bisherigen Textes sind dir sicherlich schon einige Vorteile aufgefallen. An dieser Stelle werfen wir nun noch einen genaueren Blick auf die Vorteile der Nutzung in der Kundenkommunikation, denn insbesondere in diesem Bereich kann RAG sich lohnen.

- Produktberatung im Chat: RAG ermöglicht es, dass Chatbots Informationen direkt aus Produktdatenblättern oder Katalogen ziehen. Kund*innen erhalten so präzise Empfehlungen oder Vergleiche, auch ohne Weiterleitung an den Vertrieb.

- Antworten auf komplexe Supportfragen: Statt nur Standardfragen zu beantworten, kann die KI auch bei technischen oder mehrstufigen Anliegen helfen, indem sie Informationen aus Handbüchern oder internen Dokus kombiniert.

- Automatisierte Informationsweitergabe: Egal ob Preisänderungen, Lieferverzögerungen oder neue Features – RAG sorgt dafür, dass Chatbots immer auf dem neuesten Stand antworten (sofern auch die Wissensgrundlage aktuell gehalten wird!)

- Sichere Kommunikation bei sensiblen Themen: Im Gegensatz zu frei trainierten LLMs kann RAG auf geprüfte, datenschutzkonforme Inhalte zugreifen – ein wichtiger Punkt für Branchen mit sensiblen Informationen.

- Weniger Fehlerquellen: Da RAG Informationen nicht „erfindet“, sondern gezielt abruft, sinkt das Risiko falscher Auskünfte deutlich.

Ohne RAG stößt KI-gestützte, automatisierte Kundenkommunikation schnell an ihre Grenzen.

Zwar können beispielsweise KI-Chatbots auch ohne RAG unternehmensspezifische Informationen nutzen – allerdings nur, wenn die entsprechenden Chatbot-Antworten manuell gepflegt und regelmäßig aktualisiert werden. Das ist zeitaufwendig, fehleranfällig und skaliert schlecht. Sobald sich Produktdaten, Prozesse oder Richtlinien ändern, müssen sie erneut eingepflegt werden. Fehlt dieser Schritt, liefert die KI veraltete oder unvollständige Antworten. Ohne eine automatische Anbindung an aktuelle Wissensquellen bleibt die Kommunikation also statisch.

Wie kannst du RAG in bestehende Systeme integrieren?

Beginnen wir mit der schlechten Nachricht: Eine RAG-Integration ist nichts, was man mal eben selbst zusammenklickt, vor allem nicht für den Einsatz in der Kundenkommunikation. Die Grundlagen, sprich Datenaufbereitung, Embeddings, Vektordatenbanken und Schnittstellen, erfordern viel technisches Know-how. In den meisten Fällen sind also Entwickler*innen oder Machine-Learning-Expert*innen beteiligt.

Die gute Nachricht: Viele Plattformen bieten inzwischen RAG-fähige Systeme oder APIs, die diese technische Komplexität abnehmen. Das bedeutet, dass Unternehmen RAG nutzen können, ohne selbst ein eigenes Retrieval-System aufzubauen.

Und das ist auch genau das, was ich empfehlen würde. Es gibt gute Lösungen und fachkundige Expert*innen am Markt. Bevor man sich intern in diesem Projekt "verheddert", ist es häufig sowohl einfacher als auch kostengünstiger, sich eine passende Lösung inklusive Expertise einzukaufen. Im Idealfall übernimmt ein spezialisiertes Team oder Anbieter die technische Integration – und du konzentrierst dich auf das, was zählt: gute Inhalte und eine aufgeräumte Wissensbasis.

Um den Einsatz von RAG in der Kundenkommunikation zu veranschaulichen, ein Beispiel:

Es gibt mittlerweile Chatbot-Plattformen, die RAG bereits standardmäßig integriert haben. Dort lässt sich eine Knowledge Base mit Unternehmenswissen füllen, zum Beispiel mit Produktdaten oder internen FAQs. Das System übernimmt dann die technische Logik im Hintergrund und durchsucht die Inhalte bei jeder Anfrage, bewertet sie und erstellt auf dieser Basis die Antwort.

Für dich bedeutet das: Du musst dich nicht selbst um Vektordatenbanken, Embeddings oder Retrieval-Algorithmen kümmern. Der Fokus liegt stattdessen auf der Pflege und Qualität der Inhalte, nicht auf der Technik.

Lesetipp

Lesetipp: Auch spannend: Immer mehr Kund*innen schicken ihre KI-Assistants zum Einkaufen. Alles Wichtige haben wir für dich zusammengefasst.

OMR Reviews bietet dir eine Reihe an Tools, die dich in puncto RAG unterstützen können. Hier eine Auswahl:

Fazit und Ausblick

Erst die Kombination von LLMs und RAG sorgt dafür, dass Unternehmen ihren (potenziellen) Kund*innen passgenaue, aktuelle Antworten automatisiert zur Verfügung stellen können – für mehr korrekte Inhalte, die auch skalierbar ausgespielt werden können.

RAG löst viele der Schwächen klassischer LLMs, bringt aber auch neue Anforderungen mit sich. Unternehmen müssen lernen, ihre Wissensquellen strukturiert zu pflegen und den Zugriff darauf technisch sauber zu gestalten. Aber um ehrlich zu sein, sollte man an dieser Stelle betonen, dass eine saubere Datenbasis und strukturierte Wissensquellen, ganz allgemein eine Voraussetzung für gute Arbeit sind. Auch Mitarbeiter*innen profitieren von sauberen Daten, die sie nicht ewig suchen und dann mühsam durchwühlen und interpretieren müssen, da z. B. keine einheitlichen Kategorien genutzt werden. Was gut und wichtig für die Nutzung von RAG ist, ist ebenso relevant für die menschliche Arbeit. Alle profitieren von einer sauberen Datenbasis.

Ich bin überzeugt, dass RAG künftig zum Standard in Kommunikationslösungen wird, vor allem dort, wo Kund*innen präzise, individuelle und vertrauenswürdige Informationen erwarten. In ein, zwei Jahren wird RAG vermutlich kein „Spezialthema“ mehr sein, sondern ein selbstverständlicher Bestandteil moderner Kommunikation – wie heute eine Suchfunktion oder ein Chatbot.

Gastautor*innen Aufruf

Werde Gastautor*in: Du hast in einem bestimmten Bereich richtig Ahnung und möchtest dein Wissen teilen? Dann schreibe uns einfach an reviews-experten@omr.com und bring deine Expertise ein. Wir freuen uns auf spannende Einblicke direkt aus der Praxis.