Inhalt

- Wie funktioniert Prompt Engineering?

- Arten von Prompting

- Bestandteile eines optimalen Text-Prompt

- 5 Tools für die KI-Textgenerierung mittels Prompt Engineering

Wenn du dich bereits mit einem KI-Tool wie

OpenAI ChatGPT,

neuroflash,

Creaitor oder

Retresco Textengine auseinandergesetzt hast, wird dir eines sicher aufgefallen sein: Einfach drauf loszutippen und auf das Beste zu hoffen, führt selten zum gewünschten Ergebnis. Erst, wenn du verstehst, welche Informationen du der künstlichen Intelligenz liefern musst, wirst du brauchbare Antworten erhalten. Das Zauberwort lautet in diesem Fall: Prompt Engineering! Was sich hinter diesem Begriff verbirgt, wie du für jede Anfrage den perfekten Prompt aufsetzt und vieles mehr erfährst du in diesem Artikel.

Empfehlenswerte KI-Text-Generatoren

Auf unserer Vergleichsplattform OMR Reviews findest du weitere empfehlenswerte KI-Text-Generatoren.

Über 60 verschiedene Systeme, zugeschnitten auf die spezifischen Bedürfnisse von kleinen und mittleren Unternehmen, Start-ups und großen Konzernen, stehen zur Auswahl. Unsere Plattform bietet umfassende Unterstützung in allen Bereichen der Texterstellung und -optimierung. Nutze die Chance, verschiedene KI-Tools zu vergleichen, und ziehe echte Nutzerbewertungen heran, um das perfekte Werkzeug für deine spezifischen Anforderungen zu finden:

Wie funktioniert Prompt Engineering?

Prompt Engineering bildet ein zentrales Konzept im Bereich der KI und natürlichen Sprachverarbeitung. Vereinfacht gesagt geht es darum, durch gezielte und spezifisch strukturierte Anweisungen (Prompts) die KI so mit Informationen zu füttern, dass diese die gewünschte Aufgabe erfüllt. Besonders bei den sogenannten Large Language Models (LLMs) wie GPT-3 bzw. 4 macht die Art deiner Eingabeaufforderung einen erheblichen Unterschied in der Qualität der generierten Antworten.

Das Abenteuer des Prompt Engineering geht also weit über eine einfache Mensch-Maschine-Kommunikation hinaus. Es ist eine dynamische Reise zur Optimierung und Verfeinerung der Interaktion zwischen dir und der künstlichen Intelligenz. Durch effizientes Prompt Engineering kannst du nicht nur die Effizienz steigern, mit der Befehle ausgeführt werden, sondern auch die Fähigkeiten der KI erweitern und anpassen, um komplexere und spezifischere Aufgaben zu meistern.

Arten von Prompting

Um optimale Prompts zu erstellen, ist es hilfreich, die unterschiedlichen Arten von Prompting zu verstehen. Dazu gehören:

Zero-Shot Prompting

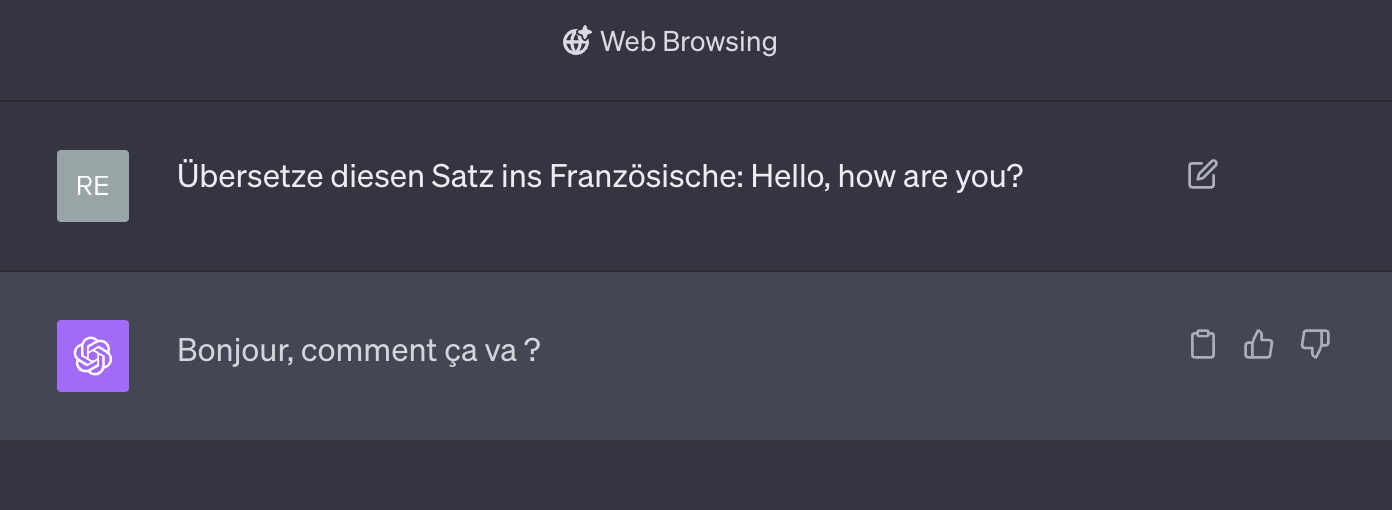

Beim Zero-Shot Prompting geht es darum, mit der KI eine Aufgabe zu erledigen, für die du sie vorher nicht explizit trainiert hast. Ein Beispiel könnte dafür sein, wenn du ChatGPT mit einer Anfrage wie dieser hier beauftragst:

Obwohl du ChatGPT nicht speziell auf diese spezifische Aufforderung trainiert hast, kann es aufgrund seiner vorherigen Trainings auf großen Textdatenbanken und seiner Fähigkeit, Muster in den Daten zu erkennen, dennoch die korrekte Übersetzung "Bonjour, comment ça va ?" liefern. In vielen Fällen und insbesondere bei simplen Anweisungen kann Zero-Shot Prompting zu brauchbaren Ergebnissen führen. Bisweilen ist es aber auch notwendig, der KI mehr Inhalte zu liefern.

Few-Shot Prompting

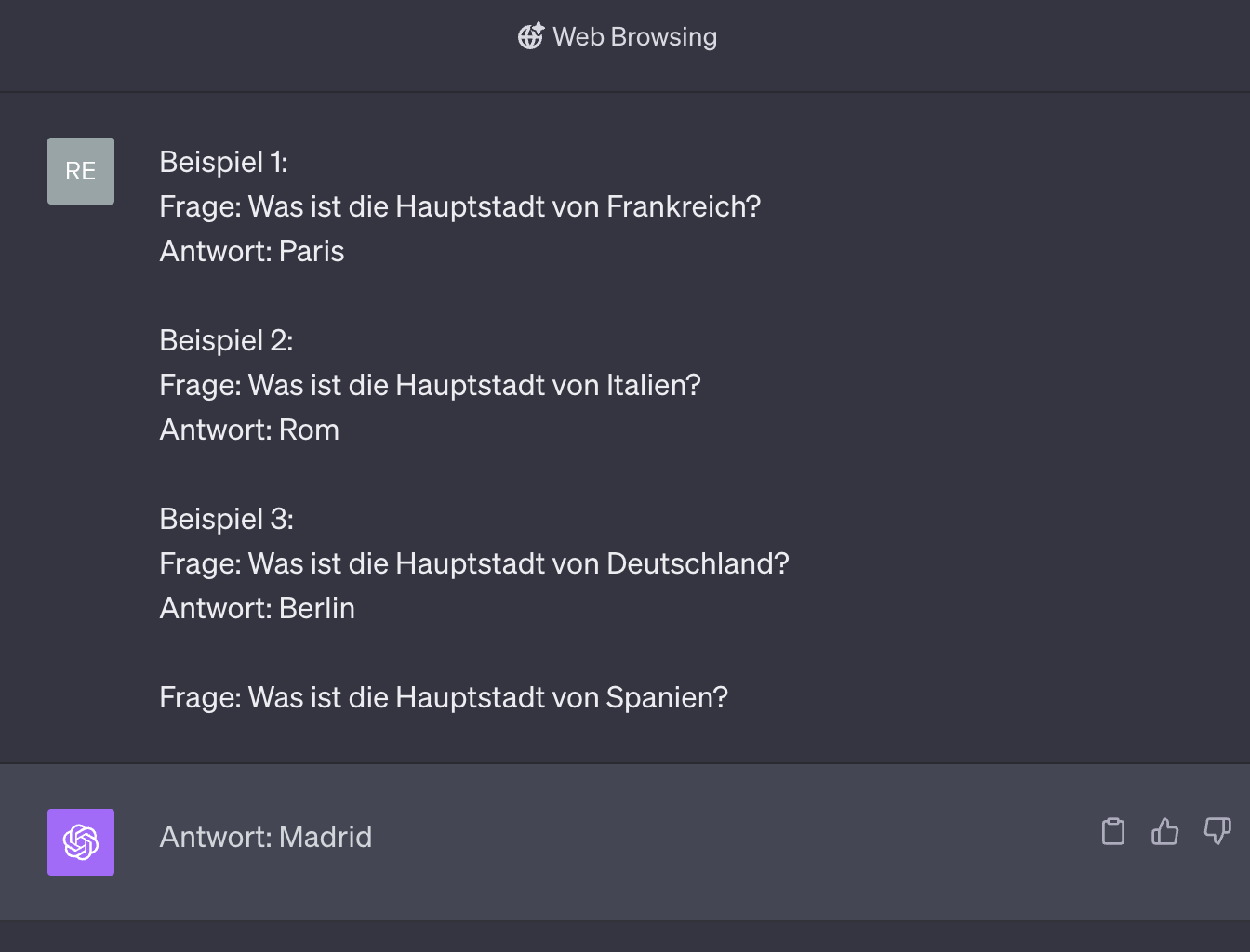

Beim One-Shot oder Few-Shot Prompting gibst du der KI ein bzw. einige Beispiele (die sogenannten “Shots”), um es auf die gewünschte Ausgabe hinzuweisen:

Das Sprachmodell kann nun, basierend auf den Mustern, die es in den vorherigen Beispielen gesehen hat, die richtige Antwort "Madrid" auf die neue Frage geben.

Chain-of-Thought (CoT) Prompting

Chain-of-Thought (CoT) Prompting ist, wie der Name schon sagt, eine Art Gedankenkette, um eine Antwort mittels künstlicher Intelligenz zu finden. Stell es dir vor wie das Lösen eines Rätsels, bei dem du jedes Stück einzeln betrachtest, bevor du das ganze Bild siehst. Diese Art des Promptings funktioniert sowohl mit Zero-Shots als auch mit Few-Shots. Ein Beispiel für das CoT Prompting wäre die folgende Anweisung, bei der du herausfinden möchtest, welcher Kontinent flächenmäßig der größte ist:

Eingabe 1: Du forderst die KI auf, alle Kontinente der Erde aufzulisten.

Eingabe 2: Du forderst die KI auf, die Flächen der einzelnen Kontinente zu vergleichen.

Eingabe 3: Nun soll die künstliche Intelligenz den flächenmäßig größten Kontinent identifizieren.

Mit diesen Anweisungen teilst du die Aufgaben für die künstliche Intelligenz in kleine Teilschritte und führst sie Stück-für-Stück zu dem gewünschten Ergebnis.

Generated Knowledge Prompting

Generated Knowledge Prompting ermöglicht es einem Sprachmodell, Wissen zu generieren, das zur Lösung einer bestimmten Aufgabe erforderlich ist, selbst wenn es nicht explizit über diese Informationen verfügt. Das kann zum Beispiel so aussehen:

Anweisung: Erkläre, warum der Himmel blau ist.

Prompt: Generiere Erklärungen zur Farbe des Himmels.

Sprachmodell generiert: Die Farbe des Himmels ist auf die Streuung von Sonnenlicht durch die Atmosphäre zurückzuführen.

Antwort: Der Himmel erscheint blau, weil das Sonnenlicht durch die Atmosphäre gestreut wird.

Bestandteile eines optimalen Text-Prompt

Ein Text-Prompt dient als Brücke zwischen dir und dem Sprachmodell und legt den Grundstein für eure Interaktion. Es ist das Sprungbrett, von dem aus die KI ihre Reise durch die Aufgabenbearbeitung beginnt. Die Gestaltung eines Text-Prompts ist eine Kunst für sich, die bestimmte Elemente berücksichtigt, um eine effektive Kommunikation und präzise Ergebnisse zu gewährleisten. Damit du immer optimale Ergebnisse erzielst, sollte dein Prompt die folgenden Bestandteile enthalten:

Rolle

Mit der Rolle kannst du der künstlichen Intelligenz eine Art Persona zuordnen auf deren Basis sie agieren soll. Du kannst das Sprachmodell beispielsweise anweisen, sich wie ein Social Media-Creator, ein*e CEO oder ein*e Redenschreiber*in zu verhalten. Das kann je nach Aufgabe zu präziseren Antworten führen.

Tonalität

Mit der Tonalität bestimmst du, in welchem Stil die Ausgabe erfolgen soll – soll der generierte Text kreativ und lustig sein? Ernst und informativ? Oder irgendwo dazwischen?

Kontext

Der Kontext ist entscheidend, um der KI den Hintergrund der Aufgabe zu erläutern. Ein guter Kontext hilft dem Sprachmodell, relevante und genaue Antworten zu generieren. Du kannst der künstlichen Intelligenz zum Beispiel erklären, in welchem Rahmen (z.B. Blogartikel, Social-Media Post, Kochbuch etc.) der generierte Text erscheinen soll oder wer die Zielgruppe ist.

Aufgabenstellung

Die Aufgabenstellung im Prompt sollte klar und direkt sein, um jegliche Verwirrung zu vermeiden. Sie sollte auch alle notwendigen Informationen enthalten, die das Modell benötigt, um die Anweisung effektiv zu lösen. Beschreibe der KI präzise, was du von ihr erwartest.

Ausgabeformat

Das gewünschte Ausgabeformat sollte im Prompt angegeben werden, wenn es spezifische Anforderungen an die Art und Weise gibt, wie die Antwort präsentiert werden soll. Dies hilft, die Ausgabe in einem nützlichen und leicht verständlichen Format zu erhalten. Du kannst die KI zum Beispiel auch anweisen, die Kapitel direkt zu formatieren (beispielsweise in H2- und H3-Überschriften).

Beachte hierbei: Natürlich muss nicht jeder Folge-Prompt alle diese Bestandteile enthalten. So genügt es in der Regel, wenn du dem Modell nur im initialen Prompt eine Rolle zuweist und die gewünschte Tonalität vorgibst.

Tipp: Wenn du dich in diesem Bereich noch weiterbilden möchtest, schau doch gerne mal bei OMR Education vorbei. Hier werden zahlreiche Weiterbildungen angeboten, darunter auch eine

Academy und ein

Deep Dive im Bereich KI.

5 Tools für die KI-Textgenerierung mittels Prompt Engineering

Neben den eingangs erwähnten Softwares gibt es zahlreiche weitere Lösungen, mit denen du in sekundenschnelle Texte erstellen kannst. Viele davon findest du mit verifizierten Bewertungen in unserer Kategorie

KI-Textgeneratoren auf

OMR Reviews. 5 beliebte Anbieter haben wir dir zudem hier schon einmal mitgebracht:

Wir wünschen dir viel Spaß beim Ausprobieren!

Retresco Textengine

Retresco Textengine Pro-Writer

Pro-Writer Jasper

Jasper ContentPipe

ContentPipe Copy.ai

Copy.ai